| ที่มา | มติชนสุดสัปดาห์ ฉบับวันที่ 12 - 18 กรกฎาคม 2562 |

|---|---|

| คอลัมน์ | Cool Tech |

| ผู้เขียน | จิตต์สุภา ฉิน |

| เผยแพร่ |

เพิ่งจะเตือนภัยเรื่อง Deepfake หรือการทำวิดีโอปลอม ที่จะเปลี่ยนให้คนในวิดีโอกลายเป็นใครก็ได้ หรือพูดอะไรก็ได้ โดยที่ดูแนบเนียนและมีวิธีการขั้นตอนที่ไม่ยุ่งยากจบไปแหม็บๆ

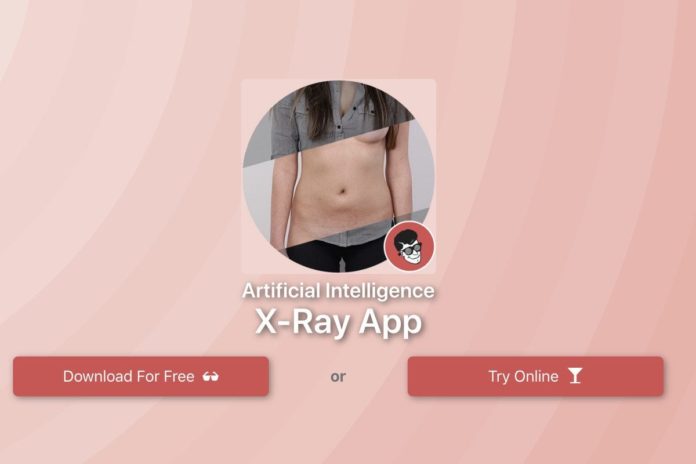

ล่าสุดก็มีข่าวการใช้ Deepfake มาทำภาพนิ่งปลอมที่มีวัตถุประสงค์หลักคือการเปลี่ยนภาพธรรมดาของผู้หญิงให้กลายเป็นภาพโป๊จนได้

เรื่องมีอยู่ว่า มีโปรแกรมเมอร์คนหนึ่งเกิดไอเดียขึ้นมาว่า เวลาเราเห็นภาพผู้หญิงที่แต่งตัวตามปกติทั่วๆ ไป ทำอย่างไรเราถึงจะสามารถเปลื้องเสื้อผ้าเหล่านั้นออกจนหมดจนเห็นเนื้อหนังมังสาข้างในได้ราวกับใช้เวทมนตร์

ถ้าเป็นคนทั่วไปคิดแบบนี้ขึ้นมาก็อาจจะแค่ใช้จินตนาการปลดเปลื้องเอาในหัว

แต่ในเมื่อคนคิดเป็นโปรแกรมเมอร์ที่สามารถใช้ทักษะสร้างเครื่องมือขึ้นมาได้

ก็เลยไปจบที่การคิดค้นซอฟต์แวร์ที่สามารถช่วยปฏิบัติภารกิจนี้ได้

การทำงานของซอฟต์แวร์นี้ก็ไม่มีอะไรยุ่งยากสำหรับฝั่งผู้ใช้งานเลย

เพียงแค่เลือกภาพคนที่แต่งตัวตามปกติ จะครึ่งท่อนหรือเต็มตัวก็ได้ เอาเข้าซอฟต์แวร์ ปล่อยให้มันทำงานสักแป๊บ ภาพนั้นก็จะออกมาเป็นภาพเปลือยที่เผยให้เห็นหน้าอกเปลือยเปล่าหรืออวัยวะเพศ

แน่นอนว่าไม่ใช่ร่างกายของเจ้าของภาพ แต่เป็นการเอาคลังภาพโป๊จำนวนมากมาเลือกสวมเข้ากับส่วนหัวของภาพที่ป้อนเข้าไป

ยิ่งเป็นภาพที่นางแบบใส่น้อยชิ้นอยู่แล้วก็ยิ่งง่าย เลือกมาจากหน้าปกนิตยสารซักภาพ แป๊บเดียวภาพนั้นก็กลายเป็นภาพโป๊สมใจอยาก

ที่บรรยายมาด้วยการเน้นภาพของผู้หญิงเป็นหลักก็เพราะว่าซอฟต์แวร์นี้ถูกออกแบบมาให้ใช้งานสำหรับภาพผู้หญิงโดยเฉพาะ

ถ้าป้อนภาพผู้ชายเข้าไป ก็จะออกมาขาดๆ เกินๆ แลดูไม่เป็นมนุษย์มนา เพราะมันถูกกำหนดมาให้ใช้กับภาพผู้หญิงเท่านั้น

ถึงนักพัฒนาเจ้าของซอฟต์แวร์จะบอกว่าในอนาคตอยากจะทำเวอร์ชั่นผู้ชายออกมาบ้างก็ตาม

เทคโนโลยี Deepfake มีศักยภาพที่จะถูกหยิบมาใช้เป็นเครื่องมือโจมตีทางการเมืองหรือทำให้คนอื่นเสื่อมเสียชื่อเสียง

แต่ที่ผ่านมาเหยื่อของเทคโนโลยีนี้ส่วนใหญ่ก็คือเพศหญิงที่ถูกหยิบภาพมาใช้โดยไม่ได้รับคำยินยอม

เริ่มตั้งแต่ดาราระดับเซเลบ ไปจนถึงผู้หญิงธรรมดาทั่วๆ ไป เป็นบ่อเกิดของภาพและคลิปโป๊ปลอมที่เจ้าตัวไม่เคยให้การยินยอมตั้งแต่แรก

ความน่ากลัวของมันก็คือการไปส่งเสริมให้ revenge porn หรือภาพโป๊ที่แฟนเก่านำออกเผยแพร่เพื่อก่อให้เกิดความอับอายกลายเป็นเรื่องที่สามารถเกิดขึ้นกับใครก็ได้ ไม่จำกัดเลยว่าคนคนนั้นเคยถูกถ่ายภาพเปลือยเอาไว้หรือเปล่า

ลองคิดดูว่า หากหน้าของเราถูกนำไปใส่เข้ากับเรือนร่างของคนอื่น แม้มันจะไม่ใช่หน้าอกของเรา ไม่ใช่อวัยวะเพศของเรา แต่ความสมจริงของมันก็คงจะทำให้เราอดไม่ได้ที่จะรู้สึกว่าตัวเองเปลือยเปล่าสู่สายตาของสาธารณชน

นำมาซึ่งความรู้สึกว่าร่างกายของเราไม่ใช่ของเราอีกต่อไป

และจู่ๆ ร่างกายของเราก็กลายเป็นสิ่งที่ทุกคนสามารถเข้าถึงได้ไม่ว่าเราจะปกปิดมันอย่างรัดกุมแค่ไหนก็ตาม

คนที่ได้ทดลองใช้ซอฟต์แวร์นี้แล้วให้ความเห็นว่าใช้งานง่ายมาก

และถึงแม้ว่าภาพผลลัพธ์ที่ออกมาจะมีลายน้ำว่า FAKE หรือปลอม ติดมาด้วย แต่ก็ง่ายมากที่จะตัดต่อออกไป

ยิ่งเป็นภาพที่ถ่ายมาด้วยกล้องมืออาชีพ แสงและเงาสมบูรณ์แบบ ก็จะยิ่งเหมือนจริงมากเท่านั้น

ผู้ผลิตซอฟต์แวร์ให้ข้อมูลว่าขั้นตอนการทำงานของมันเริ่มจากการหาตำแหน่งของเสื้อผ้าเพื่อที่จะใช้ภาพร่างเปลือยมาทดแทนได้

ในตอนนี้ยังต้องใช้เวลาทำงานต่อภาพอยู่ที่ 30 วินาที

แต่ต่อไปในอนาคตน่าจะทำได้รวดเร็วยิ่งขึ้น

แตกต่างจากวิดีโอ deepfake ที่ต้องใช้เวลาทำหลายชั่วโมง หรือหลายวัน กว่าที่จะสามารถสลับหน้าของคนในวิดีโอได้สำเร็จ

จริงอยู่ที่ภาพโป๊เหล่านี้ก็สามารถตัดต่อได้อยู่แล้วด้วยการใช้ซอฟต์แวร์อย่าง Photoshop เข้ามาช่วย

แต่คนที่จะทำแบบนั้นได้ก็ต้องมีทักษะทางด้านการตัดต่อภาพ คุ้นเคยกับเครื่องมือต่างๆ ของ Photoshop และต้องฝึกปรือมาระยะเวลาประมาณหนึ่งถึงจะสามารถทำให้ออกมาเหมือนจริงได้

เทียบกับการควักกระเป๋าซื้อซอฟต์แวร์นี้ กดปุ่มแค่ไม่กี่ครั้ง ก็ออกมาเป็นภาพโป๊ที่ต้องการให้เสร็จสมอารมณ์หมายได้ ความรุนแรงของมันจึงมากกว่าการตัดต่อในแบบเดิมเยอะ

เมื่อซอฟต์แวร์นี้กลายเป็นข่าวดังขึ้น ผู้พัฒนาก็ตัดสินใจระงับการขายออกไปก่อน

แต่เราก็น่าจะพอเดากันได้อยู่แล้วว่าต่อให้ซอฟต์แวร์นี้ไม่กลับมาขายอีกครั้ง แต่อีกไม่นานข้างหน้าก็จะมีตัวเลือกใหม่ๆ เพิ่มขึ้นมาให้หาซื้อกันได้อยู่ดี และมันจะก้าวหน้ายิ่งไปกว่านี้ ใช้เวลาน้อยกว่านี้ ง่ายกว่านี้ และเนียนกว่านี้ด้วยแน่นอน

ดังนั้น การคิดว่ามันจะหายไปเองได้ก็ดูจะเป็นความคิดที่อ่อนต่อโลกไปเสียหน่อย

แล้วเราจะทำอย่างไรถึงจะรับมือกับมันได้

คำตอบอาจจะไม่มีอะไรตายตัวเสียทีเดียว

แต่จะต้องมีกฎเกณฑ์ออกมาระงับการใช้เทคโนโลยีนี้ในแง่ที่ก่อให้เกิดความเสียหาย หรือมีข้อกำหนด บทลงโทษที่ชัดเจนและครอบคลุมกับความสมัยใหม่ของเทคโนโลยีมากขึ้น

ขณะเดียวกันแพลตฟอร์มโซเชียลมีเดียซึ่งก็น่าจะเป็นสนามปล่อยของที่ได้รับความนิยมมากที่สุดก็ควรจะต้องเตรียมรับมือกับภาพและวิดีโอ deepfake เหล่านี้ไว้ให้มั่นเช่นกัน

เช่น มีอัลกอริธึ่มที่สามารถระบุได้ทันทีว่าภาพที่ผู้ใช้งานอัพโหลดขึ้นไปเป็นภาพที่ผ่านการตัดต่อด้วยเทคโนโลยี deepfake และสามารถปลดลงได้ทันท่วงที

แต่เรื่องนี้ก็น่าจะยังต้องใช้เวลาพัฒนาต่อไปอีกสักพัก เนื่องจากที่ผ่านมาโซเชียลมีเดียก็ทำให้เห็นแล้วว่ายังอ่อนด้อยต่อการจัดการคอนเทนต์ที่ไม่เหมาะสมและไม่สามารถทำได้อย่างมีประสิทธิภาพสักเท่าไหร่

เช่น ภาพหรือวิดีโอถ่ายทอดสดเหตุการณ์รุนแรง อย่างการฆ่าตัวตาย หรือการกราดยิง ที่แพร่กระจายออกไปรวดเร็วจนไม่สามารถตามลบได้ทัน เป็นต้น

ช่องโหว่ที่เกิดขึ้นในตอนนี้คือไม่สามารถเอาผิดกับคนทำ deepfake ได้ง่ายๆ

เนื่องจากทางเทคนิคแล้ว ร่างกายที่อยู่ในภาพ “ไม่ใช่” ของเจ้าของภาพจริงๆ อาจจะทำได้อย่างมากก็แค่การดำเนินคดีเรื่องลิขสิทธิ์ภาพเท่านั้น แต่ถึงภาพเปลือยที่ออกมาจะไม่ใช่ของจริง ก็ปฏิเสธไม่ได้อยู่ดีว่ามันสามารถสร้างความอับอายและเสื่อมเสียให้กับเหยื่อได้ไม่แพ้กันเลย

ในฐานะผู้ใช้งานอินเตอร์เน็ตทั่วๆ ไป ถ้าเห็นภาพที่เรารู้อยู่แล้วว่าเป็นภาพปลอมที่ใช้ deepfake สร้างขึ้น

สิ่งที่ทำได้ก็คือ ไม่คลิก ไม่แชร์ ไม่ส่งต่อ ปล่อยให้มันล้มหายตายจากไป ไม่ว่าใครจะทำมันขึ้นมา

แต่เราต้องไม่มีส่วนเกี่ยวข้องในการแพร่กระจายมันออกไปไม่ว่าทางไหนก็ตาม ถ้าไม่ระมัดระวังให้ดีและปล่อยให้ความคึกคะนองพาไป เหยื่อที่จะเจ็บปวดอาจไม่ใช่เจ้าของภาพคนเดียวหรอก

แต่ชื่อเสียงของเราเองในฐานะคนที่ผลิตหรือส่งต่อคอนเทนต์แย่ๆ ที่ทำลายชีวิตของคนอื่นก็จะติดตัวเราไปตลอดชนิดที่ไม่มีวันสะบัดทิ้งได้เหมือนกัน